La inteligencia artificial esta entrando en una nueva fase. La euforia inicial, provocada por avances semanales o incluso diarios que redefinían lo posible, esta dando paso a una etapa que prioriza la practicidad y un mejor aprovechamiento de lo que ya tenemos. La pregunta clave ya no es "¿Qué puede hacer la IA?", sino un enfocado "¿Qué valor real aporta y cómo la implementamos de forma sostenible?". No se trata de un freno a la innovación, sino de un giro hacia despliegues estratégicos y la generación de valor tangible. Por ello en este articulo de ExplorIA, analizaremos las tendencias clave que definen este momento, basándonos en los insights que reflejan el sentir del ecosistema a principios de 2025.

Tendencias clave que definen el presente (y futuro próximo) de la IA

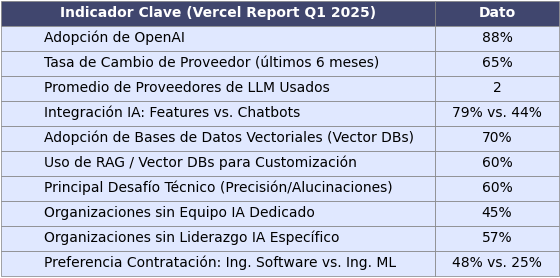

Los datos del informe de Vercel pintan un cuadro detallado del estado actual del desarrollo de IA. En la tabla de abajo, se presentan algunos indicadores clave que contextualizan las tendencias que exploraremos:

La dinámica cambiante de proveedores

Aunque OpenAI conserva una cuota de adopción dominante (cerca del 88%), el panorama de los Grandes Modelos de Lenguaje (LLMs) es mucho más dinámico de lo que esta cifra sugiere. Un dato revelador es que el 65% de los desarrolladores ha cambiado de proveedor de LLM en los últimos seis meses, y la práctica común es utilizar un promedio de dos proveedores distintos. Google y Anthropic son los principales beneficiarios de estos cambios.

Análisis estratégico: Esto refleja una madurez creciente en el ecosistema, donde los equipos ya no adoptan al líder de forma automática, sino que evalúan con más detenimiento diferentes modelos en función de sus casos de uso específicos, considerando factores como el rendimiento, el costo y las características particulares. Es una respuesta lógica a la intensa competencia y la rápida cadencia de innovación en el mercado de LLMs, donde los proveedores luchan por diferenciarse y mejorar sus ofertas constantemente.

Implicación central: La flexibilidad arquitectónica es ahora una necesidad estratégica, no un lujo. Evitar el vendor lock-in (la dependencia excesiva de un único proveedor) es una prioridad. Esto impulsa la adopción de capas de abstracción y SDKs agnósticos que permiten cambiar de modelo sin reescribir todo. La capacidad de intercambiar LLMs se convierte en una ventaja competitiva.

Visión a futuro (6-18 meses): Se provee que en los próximos meses veamos herramientas de orquestación multi-LLM más sofisticadas y benchmarks más rigurosos. La presión sobre los costos podría dividir el mercado: unos pocos LLMs gigantes y potentes (pero caros) y un ecosistema creciente de Modelos de Lenguaje Pequeños (SLMs) eficientes y especializados. La consolidación entre los grandes proveedores también es una posibilidad real.

Futurinota 📝: La lealtad al modelo es una reliquia; la agilidad arquitectónica es la nueva norma estratégica. Sin embargo, este "baile de proveedores" no es trivial: exige capas de abstracción robustas e implica una complejidad y costos operativos inherentes. Esta tensión podría acelerar la consolidación del mercado o impulsar la adopción de SLMs más eficientes para tareas específicas.

IA integrada en el núcleo

Esa etapa en que bastaba añadir "con IA" a un producto esta quedando atrás. El foco está ahora en la creación de valor tangible mediante la integración profunda de la IA en las funcionalidades centrales. Los datos lo confirman: un 79% de los equipos está integrando IA en características clave de sus productos, mientras que un 44% la utiliza solo para chatbots de soporte.

Análisis Estratégico: El objetivo es resolver problemas fundamentales, mejorar drásticamente la experiencia de usuario o habilitar capacidades nuevas, no solo añadir una capa conversacional. La IA debe ser parte del ADN del producto. Ejemplos incluyen personalización avanzada, análisis predictivo, optimización de procesos, mejora de diagnósticos médicos, creación de herramientas de diseño asistido por IA, etc.

Implicación Central: Se requiere una comprensión profunda tanto de la IA como del negocio. La diferenciación viene de cómo se usa la IA para crear ventajas únicas. La infraestructura tecnológica está madurando para soportar estas aplicaciones más complejas. La alta adopción de bases de datos vectoriales (70%) es un claro indicador. Estas bases de datos son fundamentales para técnicas como Retrieval-Augmented Generation (RAG), que permiten a los modelos usar información externa y específica del dominio para generar respuestas más precisas y contextualmente relevantes, potenciando así las integraciones profundas.

Desafío Persistente: La integración profunda amplifica el principal reto técnico: la precisión y las "alucinaciones" (respuestas incorrectas o inventadas) para el 60% de los desarrolladores. Un error en una función central del producto es considerablemente más crítico que una respuesta imprecisa de un chatbot. Esto eleva la exigencia de fiabilidad, robustez y seguridad, impulsando la mejora de técnicas como RAG avanzado, fine-tuning (aunque visto con cierto escepticismo) y marcos de evaluación y gobernanza.

Visión a Futuro (6-18 meses): Proliferarán ejemplos de IA "invisible" pero fundamental, integrada de forma nativa en productos y servicios. La personalización web podría experimentar un crecimiento significativo. La competencia se desplazará hacia la originalidad y la efectividad demostrable de las soluciones de IA integradas.

Equipos ligeros, RAG y estrategia de datos

Contrario a la idea de que la IA es solo para gigantes, equipos pequeños están implementando IA eficazmente, a menudo con presupuestos sorprendentemente ajustados (inferiores a $1,000/mes). El secreto no reside en la fuerza bruta computacional, sino en la inteligencia de la implementación.

Análisis Estratégico: Estos equipos triunfan mediante elecciones pragmáticas: usan modelos preexistentes, plataformas cloud para agilidad, frameworks modernos y dominan RAG. Un 60% usa RAG y bases de datos vectoriales para personalizar respuestas. La estrategia de datos es vital: combinan datos propietarios (~48%), de clientes (~44%), públicos (~40%) y web scraping (~40%), principalmente en formatos Texto/Markdown y PDF (~60% cada uno).

Implicación Central: RAG democratiza la IA avanzada. Permite a equipos con recursos limitados crear soluciones personalizadas y precisas. La competencia se traslada del tamaño del modelo a la inteligencia de la implementación y la calidad de los datos específicos. RAG actúa como un gran ecualizador.

Nuevos Desafíos: La dependencia de RAG y datos externos introduce complejidad en privacidad, seguridad, gobernanza y gestión del contexto. Asegurar la calidad y el manejo ético de los datos es crítico y una fuente potencial de riesgo. Los retos principales siguen siendo precisión/alucinaciones (60%), latencia/rendimiento (23%) y costos (23%).

Visión a Futuro (6-18 meses): Explosión de herramientas para optimizar RAG (evaluación, chunking, re-ranking, búsqueda híbrida). La gestión de datos para IA (calidad, linaje, privacidad) se consolidará. Podría surgir un mercado de datasets para RAG. El debate LLM vs. SLM se intensificará en el contexto de la optimización de RAG.

Futurinota 📝:La ventaja ya no reside en la escala del LLM, sino en la inteligencia de la implementación y la calidad de los datos específicos del dominio, con RAG como el habilitador clave para equipos ágiles. Sin embargo, RAG no es mágico: su eficacia depende en gran medida de la calidad de los datos y la sofisticación del pipeline de recuperación, y la precisión sigue siendo el principal desafío. Además, esta de introducir nuevas complejidades en torno a la privacidad, seguridad y gobernanza de los datos integrados.

Potenciar equipos existentes con herramientas

Sorprendentemente, muchas organizaciones (cerca del 45%) no tienen equipos dedicados a IA, y una mayoría (57%) carece de un líder específico en IA. La innovación surge a menudo desde equipos de producto existentes (~27%).

Análisis Estratégico: Esto no significa falta de inversión (un 37% dedica 5-15% del presupuesto tech a IA, un 24% incluso más). Es una estrategia deliberada: priorizar herramientas y plataformas que habiliten a los desarrolladores actuales, en lugar de crear silos de IA. La principal demanda de contratación es de Ingenieros de Software (48%), muy por encima de Ingenieros de ML (25%). Integrando la IA en el ciclo de vida del software.

Implicación Central: La IA se convierte en una competencia clave para ingenieros generalistas. Requiere inversión en formación continua y herramientas que abstraigan complejidad (SDKs, plataformas MLOps simplificadas). El modelo embebido favorece la agilidad y relevancia para el negocio. Es una "consumerización" de la IA para desarrolladores.

Riesgo Potencial: La falta de liderazgo específico en IA (57%) en un entorno descentralizado puede llevar a falta de visión estratégica unificada, inconsistencias, duplicación de esfuerzos y, principalmente, dificultades en establecer una gobernanza robusta y gestión de riesgos coherente. La agilidad de equipo podría verse comprometida por la falta de coordinación global.

Visión a Futuro (6-18 meses): Aumento de la demanda de plataformas end-to-end. Mayor énfasis en formación IA para ingenieros de software. Podrían surgir roles de "AI Lead" dentro de equipos de producto o consolidarse la necesidad de una función de gobernanza de IA (ligera pero efectiva).

Implicaciones por sector y recomendaciones

Las tendencias analizadas tienen consecuencias prácticas y estratégicas para los distintos actores del ecosistema de innovación. Aquí se presentan unas reflexiones y recomendaciones finales para afrontar los desafíos actuales:

Ingenieros/Desarrolladores: La adaptabilidad es clave. Dominen herramientas de abstracción y RAG. Piensen en la IA como parte integral del producto, enfocados en resolver problemas reales y optimizar rendimiento/costo.

Emprendedores/Innovadores: Es el momento de la innovación pragmática con equipos ágiles. La diferenciación está en la aplicación ingeniosa (RAG, datos propios) para nichos específicos o mejoras radicales. Diseñen con flexibilidad. Hay oportunidades claras (ej. personalización web).

Inversores/Estrategas: Observen la dinámica de proveedores (posible consolidación). Valoren empresas con IA práctica y centrada en valor real, no solo hype. Evalúen la madurez de la estrategia de datos y la infraestructura (RAG, Vector DBs). Las herramientas habilitadoras pueden ser una apuesta interesante.

Líderes/Decisores: Capaciten a sus equipos existentes con formación y herramientas adecuadas. Articulen una visión estratégica clara del valor de la IA. Aborden proactivamente los desafíos (precisión, seguridad, ética, gobernanza). Consideren estructuras de gobernanza ligeras si la IA está descentralizada.

Mentes Curiosas y Proactivas: Exploren RAG avanzado, IA agentica, el debate LLM vs. SLM y la creciente importancia de la seguridad y ética en IA (AI Safety).

Conclusión

La IA está madurando. El pragmatismo actual no le resta emoción; la canaliza hacia valor sostenible. Estamos construyendo la infraestructura y las metodologías para una IA ubicua y transformadora.

En los próximos 6-18 meses, esperamos ver RAG más sofisticado, gestión multi-LLM fluida, un impulso a los SLMs por eficiencia, los primeros pasos de la IA agentica (en tareas internas controladas) y una creciente centralidad de la gobernanza y la seguridad. La "fiebre del oro" de los modelos base podría dar paso a la "fiebre de las herramientas y aplicaciones", con probable consolidación entre los grandes LLMs.

La IA sigue siendo una fuerza poderosa. Quienes comprendan estas dinámicas, abracen la flexibilidad, inviertan en sus equipos y naveguen los desafíos con visión estratégica, no solo se adaptarán, sino que liderarán la construcción del futuro inteligente.

Hasta la próxima 👋